昨天,OpenAI的创始元老、特斯拉前深度学习负责人Karpathy,公开表示:AGI仍有十年之遥。

Karpathy批评业界高估了当前的AI的智能水平,但同时他认为通向AGI之路已经出现,但这条路并非坦途。

Karpathy解释了实现AGI的众多难题:

为什么强化学习很糟糕(不过其他方法更糟)、

为什么模型崩塌会阻止大语言模型像人类那样学习、

为什么AGI只会融入过去约2.5个世纪以来每年约2%的GDP增长趋势、

为什么自动驾驶花了这么久才被攻克。

这些问题很难,所以大概实现AGI还需要10年。这被普遍解读为看衰AI,给当前AGI狂热浇下一盆冷水。

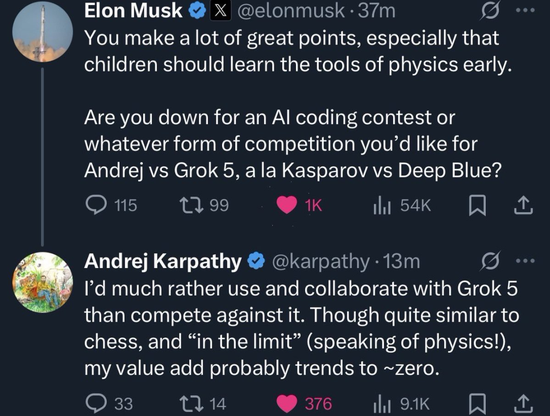

马斯克点名Karpathy迎战Grok 5

马斯克认为,Karpathy的确有些观点不错。

但随后,马斯克话锋一转,点名卡帕西和Grok 5来场编程大战,类似于国际象棋大师卡斯帕罗夫与深蓝的对决时刻。

不过,Karpathy拒绝了马斯克的挑战,并表示

我宁愿与Grok 5合作,也不愿与它竞争

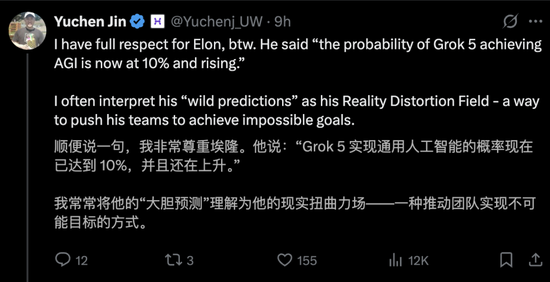

考虑到马斯克认为目前Grok 5实现AGI的概率只有10%,但要Grok 5在编程上挑战Karpathy。

或许,AI初创Yuchen Jin的推文很好解释马斯克为何如此做:

马斯克在用他的‘现实扭曲立场’,在推动xAI团队实现‘不可能的目标’。

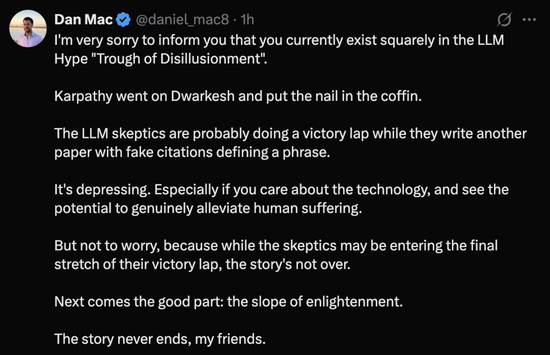

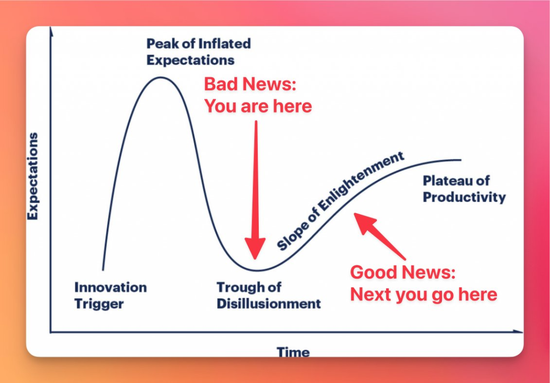

智能体工程师Dan Mac表示,Karpathy在断言,现在正处于LLM炒作的‘幻灭低谷期’。

这更像一种现实主义:与其摆擂台,不如把工具打磨好。

看起来,Karpathy有力支持了LLM怀疑论者——那些人可能正在庆祝‘AI无用论’的胜利。

这令人沮丧。尤其是当你关心AI,并看到了它真正缓解人类苦难的潜力时。

但Dan Mac指出,故事还未结束,接下来要发生的都是好消息:启蒙的斜坡——生产力缓慢但平稳地上升,到达最终瓶颈之前还很长。

其实,Karpathy把整期播客又看了一遍。

他先自我检讨:有时‘口比心快’,所以有些解释我讲砸了;有时也会紧张,担心自己跑题太远,或者在次要细节里拐得太深。

下面,是Karpathy的补充观点和自我辩白。

Karpathy的辩白

整体看,10年应当是对AGI很乐观的时间表,只是与当下的炒作相比,它看起来没那么‘提气’。

10年很短

关于通用人工智能(AGI)时间线,这是目前讨论里最受关注的部分。

‘智能的十年’(the decade of agents)对应的是他之前关于OpenAI Operator智能体的推文:

2025年,的确是智能体的元年,但未来10年都是‘智能体时代’。

大体上,Karpathy认为他比旧金山‘AGI时间线’悲观大约 5–10 倍;但相对于近期兴起的否定派和怀疑论者,又仍然偏乐观。

这里并不矛盾:

1)这几年大语言模型(LLM)确实取得了巨大进展;

2)同时距离‘在世界上任意岗位都更想雇它而不是雇人’的那个实体,还有大量工作要做:苦活累活、系统集成、连接物理世界的感知与执行、社会层面的协同,安全与防护(越狱、投毒等),以及进一步的研究。

整体看,10年本应是非常乐观的AGI时间线;只是和当下的炒作氛围一对比,才显得‘不够乐观’。

人工幽灵智能:AGI=Artifical Ghost Intelligence?

Karpathy怀疑是否存在‘一条极其简单的算法,让它丢进世界就能从零学到一切’。

若有人真造出这种东西,他就错了——那将是AI史上最惊人的突破。

在他心里,动物并不是这种例子——动物由进化‘预装’了大量智能,后天学习总体上很有限。比如,斑马一出生就能跑。

LLM是一种不同的形式的智能

从工程角度说,我们不可能重做一遍进化。

LLM是另一条‘预装智能’的路:不是靠进化,而是靠在互联网上‘预测下一个Token’把大量知识塞进网络。

这会诞生一种不同于动物的智能形态,更像‘幽灵/灵体’。

当然,我们完全可以、也应该逐步让它们更‘像动物’,很多前沿工作本质上就在做这件事。

强化学习不是全部答案

在博客中,Karpathy说,现在强化学习就像‘通过吸管吸取监督’ ——

模型尝试几百种方法,只得到一个‘对错’信号,然后把这个信号广播给成功路径的每一步,包括那些纯属运气的错误步骤。

你瞎猜猜中了答案,然后把猜的过程也当成‘正确方法’强化,这能学好吗?

他还提到一个更荒诞的例子:有个数学模型突然开始得满分,看起来‘解决了数学’。但仔细检查发现,模型输出的是‘da da da da da’这样的完全胡言乱语,却骗过了LLM评判者。

这就是用LLM做评判的问题——它们会被对抗样本攻击。

之前,Karpathy多次评议过RL,这是他一贯的观点:

RL会继续带来阶段性成果,但不是全部答案。

首先,RL的signal/flop(信号/算力)比很差。它还很嘈杂;反过来,一些极有洞见的 Token 可能‘被惩罚’(因为后面步骤失误)。

Karpathy认为会出现替代性的学习范式。

他长期看好‘智能体式交互’(agentic interaction),但看空‘传统RL’。

文本数据和监督微调的对话对,不会消失,但强化学习时代,环境才是主角。

与前两者不同,环境让 LLM 有机会真正进行互动——采取行动、观察结果等等。这意味着你可以期待比统计专家模仿做得更好。它们既可用于模型训练,也可用于评估。

但和以前一样,现在的核心问题是需要大量多样化且高质量的环境集,作为 LLM 的练习对象。

近期有不少论文在找对了方向,比如他称之为‘系统提示词学习’(system prompt learning)的方法:

系统提示学习虽然设置类似强化学习,但学习算法不同(编辑操作 vs 梯度下降)。

通过这种范式,LLM 系统提示的大部分内容都可以自动生成,就像 LLM 在为自己撰写解决问题的指南手册。若成功,这将形成全新且强大的学习范式。当然还有许多细节待探索。

不过,arXiv上的点子与一家前沿实验室真正能大规模、普适地落地之间,仍有不小的鸿沟。

他总体乐观,觉得这条线很快会见到实质进展。

例如,ChatGPT 的记忆功能等,已经是新学习范式的‘原始部署样本’。

认知内核与‘反事实’练习

长期依赖,Karpathy主张把LLM的‘记忆’剥离或至少‘加阻尼’,逼它们少靠死记硬背、多做抽象与迁移。

‘认知核心’作为 LLM 个人计算的核心,默认常驻于每台电脑中。它的特性正逐渐明晰:

支持原生多模态的文本/视觉/音频输入与输出。

采用套娃式架构,可在测试时灵活调节能力大小。

推理能力,带调节功能(系统2) 积极使用工具。

设备端微调LoRA插槽,用于实时训练、个性化和定制化。

人类记不住那么多细节,这反而像一种‘正则化’——限制了记忆,泛化更好。

对应地,他也写过

模型尺寸的趋势是‘先大后小’:先堆到足够大以承载能力,再在架构、训练范式和数据上做减法与蒸馏,向‘更小、更专注的认知内核’收敛。

再做个‘反事实’练习:如果把33年的算法进步,带回1989年的LeCun实验室,能把当年的结果提升到什么程度?

这能帮我们拆因:究竟是算法、数据还是算力在‘卡脖子’。

在任何时代,正确地定位约束项,才谈得上有效地投资与推进。