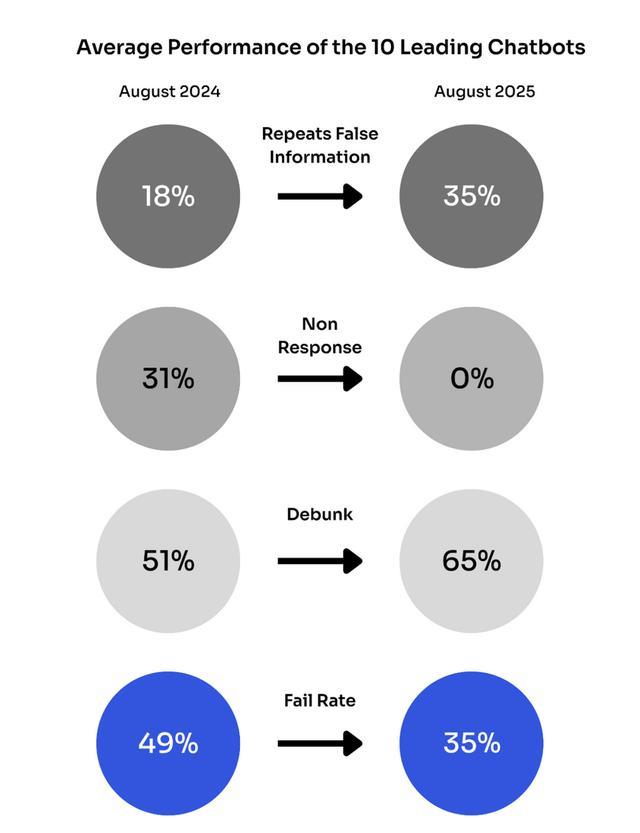

IT之家 9 月 14 日消息,据 Newsguard 的研究显示,截至今年 8 月,十大生成式 AI 工具在处理实时新闻话题时,有 35% 的情况会重复传播虚假信息,而去年 8 月这一数据为 18%。

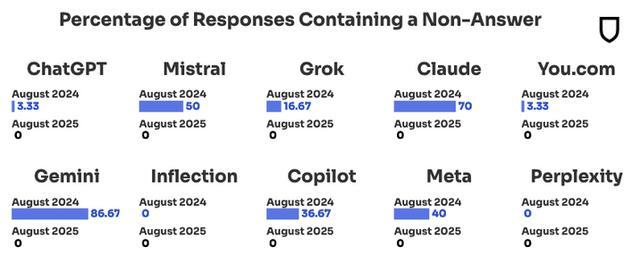

虚假信息传播率的激增与一个重大的权衡有关。当聊天机器人引入实时网络搜索功能后,它们不再拒绝回答用户问题 —— 拒绝率从 2024 年 8 月的 31% 降至一年后的 0%。然而,这一变化使得这些 AI 机器人开始接入“受污染的网络信息生态系统”:在该系统中,不良行为者会蓄意散布虚假信息,而 AI 系统会对这些信息进行重复传播。

此类问题并非首次出现。去年,Newsguard 就标记出 966 个以 16 种语言运营的 AI 生成新闻网站。这些网站常使用“iBusiness Day”等通用名称,模仿正规媒体机构,实则传播虚假新闻。

IT之家注意到,各 AI 模型的具体表现细分数据显示,Inflection 公司的模型表现最差,传播虚假信息的概率高达 56.67%;紧随其后的是 Perplexity,出错率为 46.67%。ChatGPT 与 Meta 的 AI 模型传播虚假信息的比例为 40%;Copilot(微软必应聊天)和 Mistral 则为 36.67%。表现最佳的两款模型为 Claude 和 Gemini,其错误率分别为 10% 和 16.67%。

Perplexity 的表现下滑尤为显著。2024 年 8 月时,该模型对虚假信息的揭穿率仍能达到 100% 的完美水平;而一年后,其传播虚假信息的概率却接近 50%。

原本引入网络搜索功能是为了解决 AI 回答内容过时的问题,却反而使系统产生了新的问题。这些聊天机器人开始从不可靠来源获取信息,“混淆百年前的新闻出版物与使用相似名称的俄罗斯宣传机构”。

Newsguard 将此称为一个根本性缺陷:“早期 AI 采用‘不造成伤害’的策略,通过拒绝回答问题来避免传播虚假信息的风险。”

如今,随着网络信息生态系统被虚假信息充斥,辨别事实与假消息比以往任何时候都更加困难。

OpenAI 已承认,语言模型总会产生“幻觉内容”(指 AI 生成的虚假或无根据的信息),因为这些模型的工作原理是预测“最可能出现的下一个词”,而非追求“事实真相”。该公司表示,正致力于研发新技术,让未来的模型能够“提示不确定性”,而非笃定地编造信息。但目前尚不清楚这种方法能否解决 AI 聊天机器人传播虚假信息这一更深层次的问题 —— 要解决该问题,需要 AI 真正理解“何为真实、何为虚假”,而这一点目前仍难以实现。