IT之家 11 月 8 日消息,据科技媒体 the decoder 今天报道,一项由牛津大学、华盛顿大学等机构发表的国际研究指出,目前大多数大语言模型(LLM)的测试标准存在严重方法论问题,使人们很难真正客观地衡量 AI 的进步。

科学家们翻阅了顶级 AI 学术会议(IT之家注:涵盖 ICML、ICLR、NeurIPS、ACL 等)从 2018 年到 2024 年间发表的 445 篇基准测试论文,并邀请 29 名专家进行评判,结果发现这些论文里都至少存在一个重大缺陷。

据研究报告所述,这其中的许多基准定义都含糊其辞或存在争议,虽然 78% 的基准能说明内容,但其中的一半都没有清晰定义“推理”、“对齐”、“安全性”等关键术语,从而使这些论文的结论缺乏可信度。

此外,大约 61% 的基准测试评估了复合技能,如“智能体行为”,这些测试通常同时涉猎意图、生成结构化输出等多个子集,而这些子集很少能被单独评估,因此结果往往难以解释。

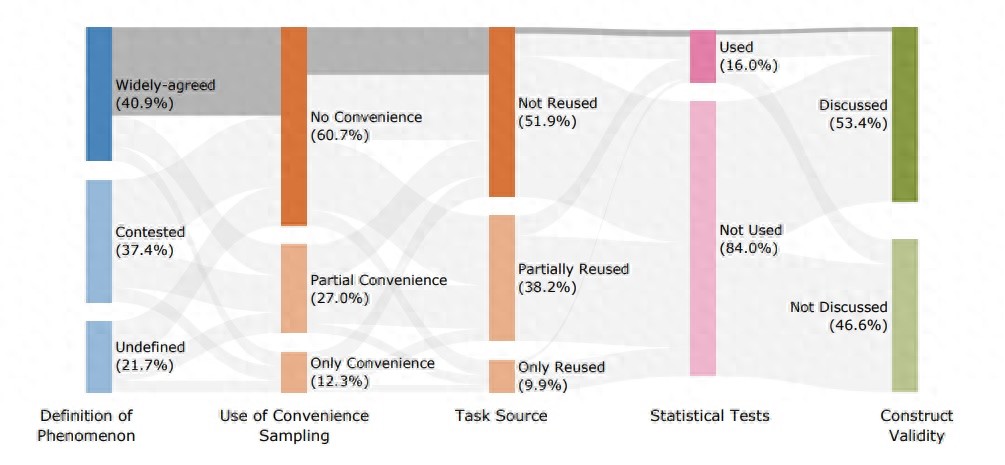

同时数据采样也是基准测试的重灾区之一,约 93% 的论文使用了便利抽样,12% 的论文完全依赖便利抽样,不能代表真实使用场景,还有 38% 的测试复用了数据,许多研究甚至会直接使用其它测试集,这种做法很可能扭曲 LLM 的实际表现,无法反映模型在复杂数学推理的真实能力。

此外,超过 80% 的研究使用“完全匹配率”作为评分标准,但只有 16% 使用统计校验方法来比较不同模型差异,还有 13% 使用人工评判,大多数测试都没有提供不确定性统计、置信区间,使结果可信度大打折扣。

当然团队也提出了改进方向,他们建议后续测试中需明确定义测试目标和边界,确保不在过程中混入无关任务,需要防止数据污染,并使用严谨的统计与误差分析,从定量和定性两方面下手,让研究结果更准确。